Die Branche setzt aufs falsche Pferd - eine Meta-Analyse zum KI-Einsatz

Veröffentlicht am 20. Juli 2025 - ⏱️ Ca. (wird berechnet) min. Lesezeit

Die Atomspaltung galt einst als Fortschritt. Ein Triumph der Wissenschaft, ein Versprechen unbegrenzter Energie. Erst später wurde sichtbar, wie zerstörerisch ihr Potenzial ist.

Ein ähnlicher Moment lässt sich derzeit in der Softwarebranche beobachten: Künstliche Intelligenz erscheint bahnbrechend, ihre Möglichkeiten scheinen weitreichend. Doch bei näherem Hinsehen entpuppt sich vieles als Fassade.

Was als Quantensprung in der Produktivität verkauft wird, ist bei realen Projekten oft kaum messbar. Studien zeigen: Die vermeintlichen Effizienzgewinne bleiben in der Breite marginal. Gerade dort, wo Komplexität, Architekturverantwortung und Teamarbeit zählen wirkt sie sogar destruktiv. Am meisten profitieren scheinbar die Unerfahrenen. Zumindest oberflächlich. Denn während der Output steigt, stagniert der Kompetenzaufbau.

Und dennoch wird KI flächendeckend eingeführt. Nicht aus strategischer Überzeugung, sondern als reflexartige Reaktion. Ausbildung wird ersetzt durch Autovervollständigung, Eigenverantwortung durch Prompting. KI wird nicht methodisch implementiert, sondern idealisiert. Die Frage lautet selten: „Wo bringt sie konkret Nutzen?“, sondern: „Wie schnell können wir alles umstellen?“

So entsteht ein Risiko. Überzogene Erwartungen, unreflektierte Umstellungen und strukturelle Verschiebungen bedrohen genau jene Prinzipien, die langfristige Stabilität sichern.

Dieser Artikel ist ein Plädoyer für Klarheit und inmitten eines technologischen Hypes eine unbequeme Frage zu stellen: Was, wenn der versprochene Gewinn nicht eintritt und der eigentliche Einsatz viel höher ist, als es irgendjemand kalkuliert hat?

Die Wahrheit über Effizienz von KI in der Softwareentwicklung

Empirisch lässt sich das Bild klarer zeichnen: Eine Auswertung mehrerer unabhängiger Studien zeigt, dass der Produktivitätsgewinn durch KI-gestützte Entwicklung stark variiert. Je nach Komplexität der Aufgabe und Erfahrung der Beteiligten.

Zentrale Frage dabei: Wird nur der Output bewertet, oder auch die Qualität? Viele Studien wie Peng et al. (2023), Microsoft Studies (2023) oder Upwork (2024) messen vor allem Quantität – etwa erzeugte Zeilen Code – ohne zu prüfen, ob die Ergebnisse korrekt waren oder später zurückgenommen werden mussten. Für eine realistische Einordnung wurden daher nur Studien berücksichtigt, die Qualität explizit mitbewerten.

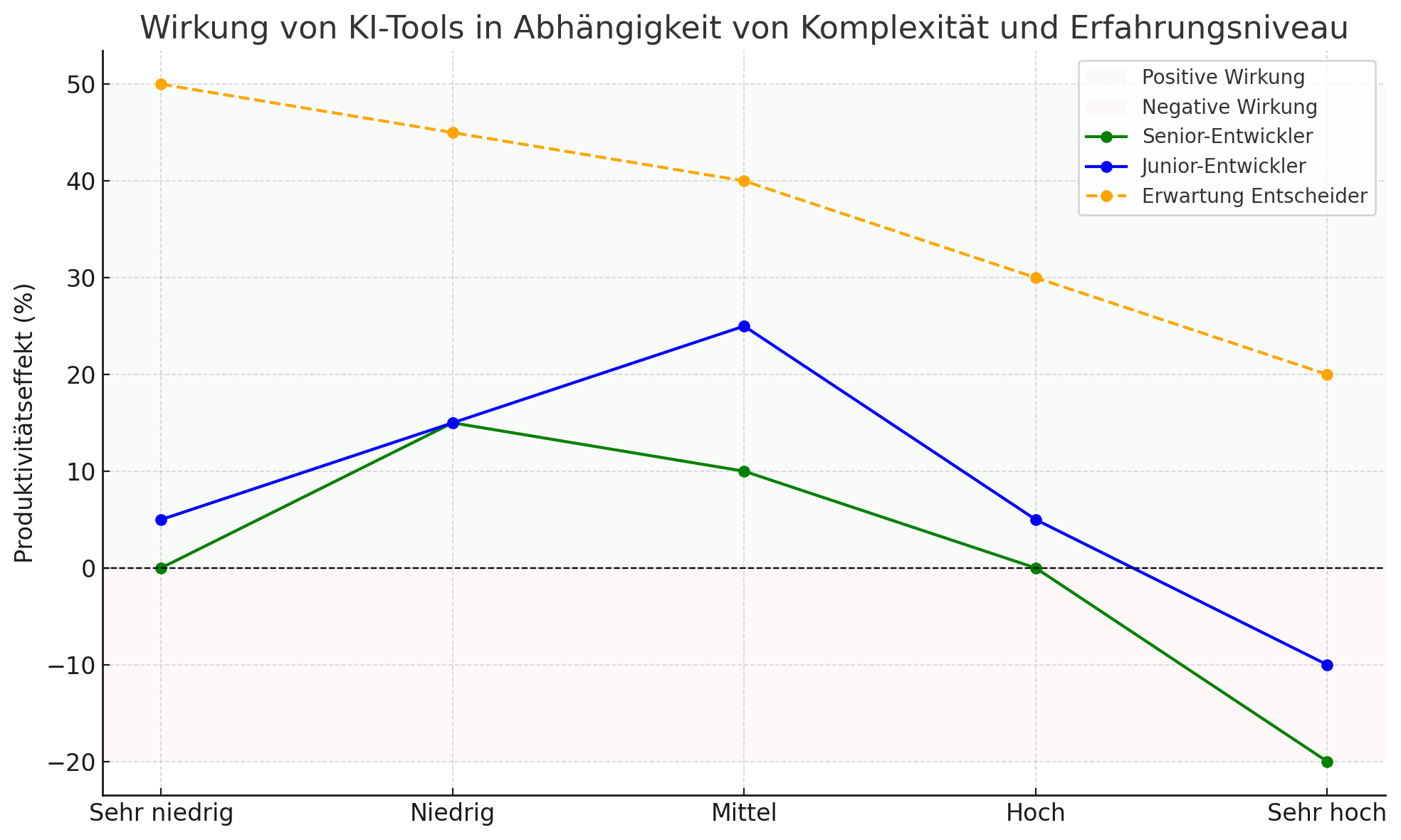

Die folgende Grafik verdichtet zentrale Ergebnisse dieser Studien. Sie zeigt, wie stark der Produktivitätsgewinn (oder -verlust) durch KI ausfällt und wie er sich je nach Komplexität und Erfahrungsniveau verändert.

Die Ergebnisse legen nahe: Der Nutzen KI-basierter Entwicklungswerkzeuge ist nicht linear. Je komplexer die Aufgabe und je erfahrener die Entwickler, desto geringer fällt der tatsächliche Produktivitätsgewinn aus und kehrt in manchen Fällen sogar ins Gegenteil. Besonders auffällig: Während einfache Tätigkeiten in der Fläche beschleunigt werden, entstehen bei hoher Projektkomplexität und senioren Teams zunehmend Friktionen. Die Grafik zeigt: Der vermutete Quantensprung bleibt aus. Genau dort, wo strukturelles Denken, Kontextverständnis und Verantwortung gefragt sind, wird der Einsatz von KI-Tools zur Belastung.

Gleichzeitig gibt es aber bei niedriger, bis mittlerer Komplexität einen sweet-spot. Hier profitieren sowohl unerfahrene als auch erfahrene Entwickler. Das legt den Schluss nahe, dass triviale Aufgaben schneller gelöst sind, ohne die KI zu bemühen und zu instruieren. Gerade bei niedriger Komplexität nähern sich Senior und Junior entwickler an. Bei diesen Aufgaben kann die KI ihre grösste Wirkung entfalten. Das sind Aufgaben, die simpel genug sind, sodass sie einfach geprüft werden können, aber gleichzeit mühsam genug, sodass die KI hier einen Produktivitätsvorteil verschafft. Bei mittlerer Komplexität sieht man wieder den Vorteil der erfahrenen Entwickler. Sie wissen wie das Problem zu lösen ist und haben daher weniger Vorteile als Junior Entwickler, denen die KI hier bei der Recherche und dem Verständnis helfen kann. Sobald die Komplexität ein gewisses Niveau erreicht sinkt die Produktivität ins Negative. Der Aufwand die KI zu instruieren steigt immer weiter an, gleichzeitig werden die Ergebnisse schlechter. Nicht selten lockt einen die AI auf eine falsche Fährte oder produziert unsinnigen Code, wodurch gerade erfahrene Entwickler viel schneller sind, wenn sie auf ihr Können vertrauen und systematisch das Problem lösen.

Auffällig ist auch: Die wahrgenommene Effizienz durch Entscheider unterscheidet sich deutlich von den gemessenen Werten. Fast alle Studien zeigen, dass der tatsächliche Zugewinn massiv überschätzt wird.

Die vorliegende Auswertung basiert auf einer Meta-Analyse von acht Studien und Branchenberichten aus den Jahren 2022 bis 2025. Berücksichtigt wurden ausschließlich Arbeiten, die konkrete Messwerte zur Wirkung von KI-basierten Codeassistenzsystemen wie GitHub Copilot, ChatGPT oder Amazon CodeWhisperer aufzeigen - sei es in Form kontrollierter Experimente, Telemetriedaten oder qualitativer Effekte in produktiven Entwicklungskontexten.

Die Studien wurden in zwei Dimensionen kategorisiert: Komplexität der Aufgabenstellung (von einfachen Einzeltasks bis zu tiefen Eingriffen in gewachsene Codebasen) und Erfahrungsgrad der Beteiligten (Junior- vs. Seniorentwickler mit mehreren Jahren Projekterfahrung). Effekte wie Beschleunigung, Verlangsamung, kognitive Belastung, Qualitätseinbußen und Review-Overhead wurden vergleichend eingeordnet.

Die daraus abgeleitete Grafik ist keine exakte Reproduktion einzelner Datensätze, sondern eine strukturierte Synthese der dokumentierten Trends: Wo Studien vergleichbare Muster zeigen, wurden aggregierte Verlaufskurven gezeichnet - insbesondere für die Differenzierung zwischen Junior- und Seniorentwicklern. Die grün und rot unterlegte Null-Linie dient zur Visualisierung von Produktivitätsgewinnen bzw. -verlusten.

Ausgewertete Quellen

- Cui, Kevin Z. et al. (2024): The Effects of Generative AI on High-Skilled Work –

Feldstudien bei Microsoft, Accenture und Fortune-100-Firma (RCT)

Link – Verwendet für Alle Entwickler, Senior, Junior, v.a. mittlere bis hohe Komplexität - Vaithilingam, Priyan et al. (2022): Evaluating the Usability of Code Generation

Tools – Kontrolliertes Experiment mit Copilot vs. Intellisense

Link – Verwendet für Junior, sehr niedrig/niedrig komplexe Tasks (kein signifikanter Produktivitätsgewinn) - Becker, Rush et al. (2025): Measuring the Impact of Early-2025 AI – Feldstudie mit

Open-Source-Senior-Entwicklern

Link – Verwendet für Senior bei sehr hoher Komplexität (–20%), real gemessener Negativtrend - eBay Developer Ecosystem Team (2024): A/B-Test zu Copilot Enterprise –

Industriebericht im Blog/InfoQ

Link – Verwendet für Alle Entwickler bei niedriger bis mittlerer Komplexität - Bird, Christian et al. (2022): Interne Microsoft-Studie zu Copilot-Nutzung –

Beobachtung & Befragung zur Effizienz realer Entwickler

Link – Verwendet für Bewertung realer Produktivitätskosten bei Codekorrektur - Dakhel, Arghavan M. et al. (2023): GitHub Copilot – Asset or Liability? –

Systematische Testaufgaben, Fokus auf Anfänger vs. Profis

Link – Verwendet für Junior (Liability bei hoher Komplexität), Senior (Asset bei einfachen Tasks) - Nguyen, Nhan & Nadi, Sarah (2022): An Empirical Evaluation of GitHub Copilot’s Code

Suggestions – Quantitative Analyse von Copilot-Outputs bei LeetCode-Problemen

Link – Verwendet für Junior bei niedriger/mittlerer Komplexität, Aussage zu Korrektheitsquote - Choudhuri, Shurui et al. (2024): The Triumphs and Trials of Generative AI in Learning

SE – Experiment in Kursumgebung – GPT bei realen Software-Problemen

Link – Verwendet für Junior bei hoher Komplexität (Frustration trotz KI), kein Zeitgewinn

Verdrängung statt Strategie: Warum der KI-Rausch gefährlicher ist, als es scheint

Wenn der Nutzen fraglich ist, aber die Einführung dennoch massiv vorangetrieben wird, liegt der Verdacht nahe: Die Branche handelt nicht evidenzbasiert, sondern reflexhaft.

Statt auf differenzierte Pilotierung und valide Erfolgsmetriken zu setzen, folgen viele Entscheider einem einfachen Narrativ: Wer jetzt nicht umstellt, verliert den Anschluss. KI wird nicht eingeführt, weil sie wirkt, sondern weil man glaubt, sie müsse wirken. Der Druck, nicht abgehängt zu werden, überlagert jede nüchterne Analyse.

Die Folge: KI-Tools werden pauschal ausgerollt, ohne Berücksichtigung von Teamstruktur, Erfahrungslevel oder Projektcharakteristik. Auch erfahrene Teams werden in den Prompting-Tunnel gedrückt, obwohl gerade dort nachweislich die geringsten oder gar negativen Effekte messbar sind.

Dennoch hält sich der Schaden dieses Vorgehens - wie in der Grafik gut sichtbar ist - in Grenzen. Zumindest was die Produktivität betrifft. Der wahre Schaden, der verborgene, der die gesamte Branche langfristig gefährdet, ist leise: In der Abschaffung der Ausbildung junger Entwickler.

Output ohne Aufbau: Wie KI-Tools die nächste Entwicklergeneration schwächen

KI-Tools ermöglichen es Unerfahrenen, schneller funktionierenden Code zu liefern. Doch was dabei verloren geht, ist das Verständnis. Die traditionelle Lernkurve - bestehend aus Scheitern, Reflektion, Austausch und Review - wird durch Vorschläge ersetzt, die selten wirklich durchdrungen werden.

Mentoring, Pair Programming, Code Reviews werden unter dem Diktat kurzfristiger Produktivität zurückgefahren. Der Output steigt, die fachliche Tiefe sinkt. Was entsteht, ist eine neue Entwicklergeneration, die produziert, aber nicht versteht.

Noch gravierender ist: Der Verlust betrifft nicht nur individuelle Lernkurven, sondern das kollektive Erfahrungswissen ganzer Teams. Wer mit KI als Erstzugang beginnt, lernt nicht mehr, sauber zu abstrahieren, Architekturen zu entwerfen oder technische Schuld zu erkennen. Dieses Wissen entsteht nicht durch Output, sondern durch Auseinandersetzung. Doch genau diese wird systematisch verkürzt.

Langfristig entsteht so eine Kluft: Zwischen jenen, die Systeme gestalten, und jenen, die nur noch bedienen. Zwischen tiefem Verständnis und bloßem Interfacing. Die Folgen werden erst Jahre später sichtbar: Wenn Entscheidungsfähigkeit, Ownership und Reflexionsvermögen fehlen.

Von Tool-Gläubigkeit zu Architektur-Kompetenz: Wie ein kluger KI-Einsatz aussieht

KI kann sinnvoll eingesetzt werden! Gerade die Grafik zeigt: Bei Aufgaben mit geringer Komplexität zeigt die KI ihre wahre Stärke. Sei es die Generierung einer Landing-Page, einfache Skripte oder standardisierte Funktionen. Hier kann jeder Entwickler erfolgreich die Abkürzung nehmen und den Agenten arbeiten lassen.

Doch dort, wo Architekturverständnis und tiefes Systemwissen gefragt sind, braucht es menschliche Expertise. Refactoring, hinterfragen und Sicherheitsfragen. All das, was kein Tool liefern kann und kontextbewusstes Urteilsvermögen verlangt.

Wer KI-Werkzeuge einführt, braucht Governance. Klare Regeln, Schulung, Evaluation. Ohne diese Leitplanken wird der erhoffte Produktivitätsschub schnell zum strukturellen Risiko.

Die Branche steht an einem Scheideweg: Zwischen kurzfristigem Output und nachhaltiger Substanz. Wer heute glaubt, Effizienz lasse sich einfach prompten, wird morgen feststellen, dass ohne Verständnis keine Qualität entsteht und ohne Qualität kein Fortschritt. Es braucht Mut zur Differenzierung. Und den Willen, Ausbildung nicht durch Tools zu ersetzen, sondern durch sie zu ergänzen.

Es ist nicht der Mangel an KI, der uns gefährlich wird. Sondern der Verlust an Substanz, wenn niemand mehr versteht, was gute Software ausmacht